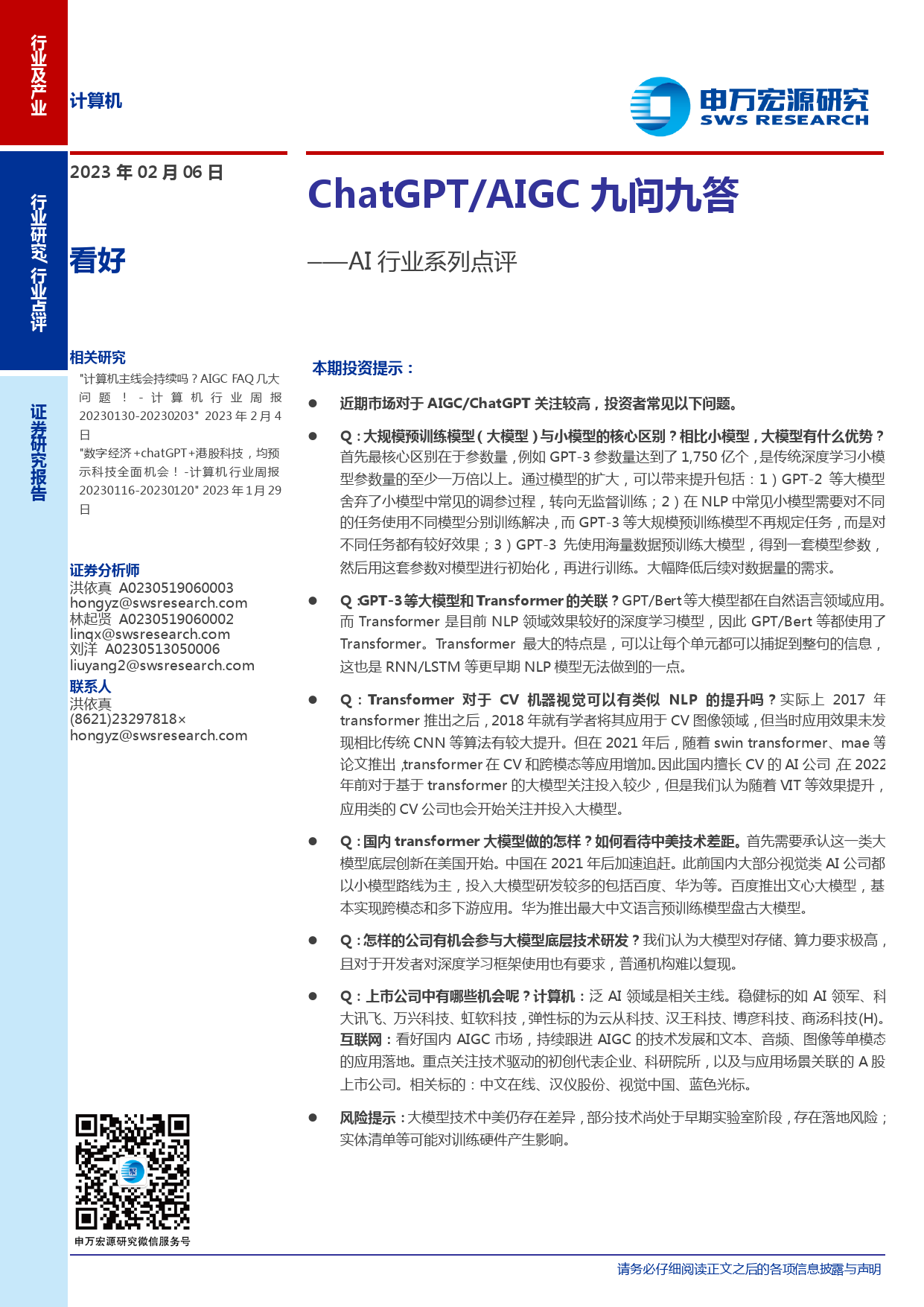

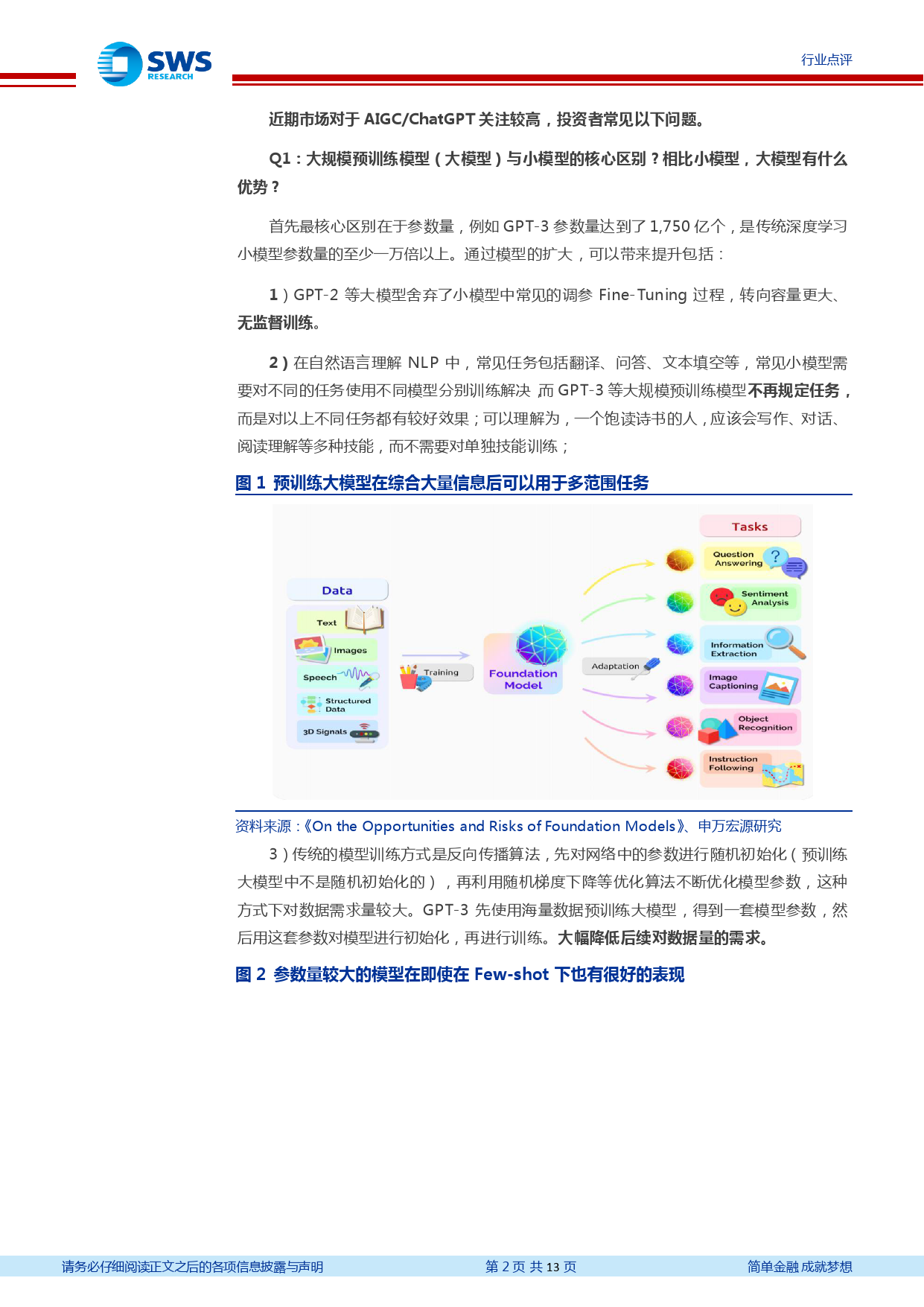

行业及产业计算机2023年02月06日/ChatGPT/AIGC九问九答看好行——AI行业系列点评业研究行业点评相关研究本期投资提示:"计算机主线会持续吗?AIGCFAQ几大证问题!-计算机行业周报近期市场对于AIGC/ChatGPT关注较高,投资者常见以下问题。20230130-20230203"2023年2月4券日研Q:大规模预训练模型(大模型)与小模型的核心区别?相比小模型,大模型有什么优势?究"数字经济+chatGPT+港股科技,均预首先最核心区别在于参数量,例如GPT-3参数量达到了1,750亿个,是传统深度学习小模报示科技全面机会!-计算机行业周报型参数量的至少一万倍以上。通过模型的扩大,可以带来提升包括:1)GPT-2等大模型告20230116-20230120"2023年1月29舍弃了小模型中常见的调参过程,转向无监督训练;2)在NLP中常见小模型需要对不同日的任务使用不同模型分别训练解决,而GPT-3等大规模预训练模型不再规定任务,而是对不同任务都有较好效果;3)GPT-3先使用海量数据预训练大模型,得到一套模型参数,证券分析师然后用这套参数对模型进行初始化,再进行训练。大幅降低后续对数据量的需求。洪依真A0230519060003Q:GPT-3等大模型和Transformer的关联?GPT/Bert等大模型都在自然语言领域应用。hongyz@swsresearch.com而Transformer是目前NLP领域效果较好的深度学习模型,因此GPT/Bert等都使用了林起贤A0230519060002Transformer。Transformer最大的特点是,可以让每个单元都可以捕捉到整句的信息,linqx@swsresearch.com这也是RNN/LSTM等更早期NLP模型无法做到的一点。刘洋A0230513050006liuyang2@swsresearch.comQ:Transformer对于CV机器视觉可以...

发表评论取消回复