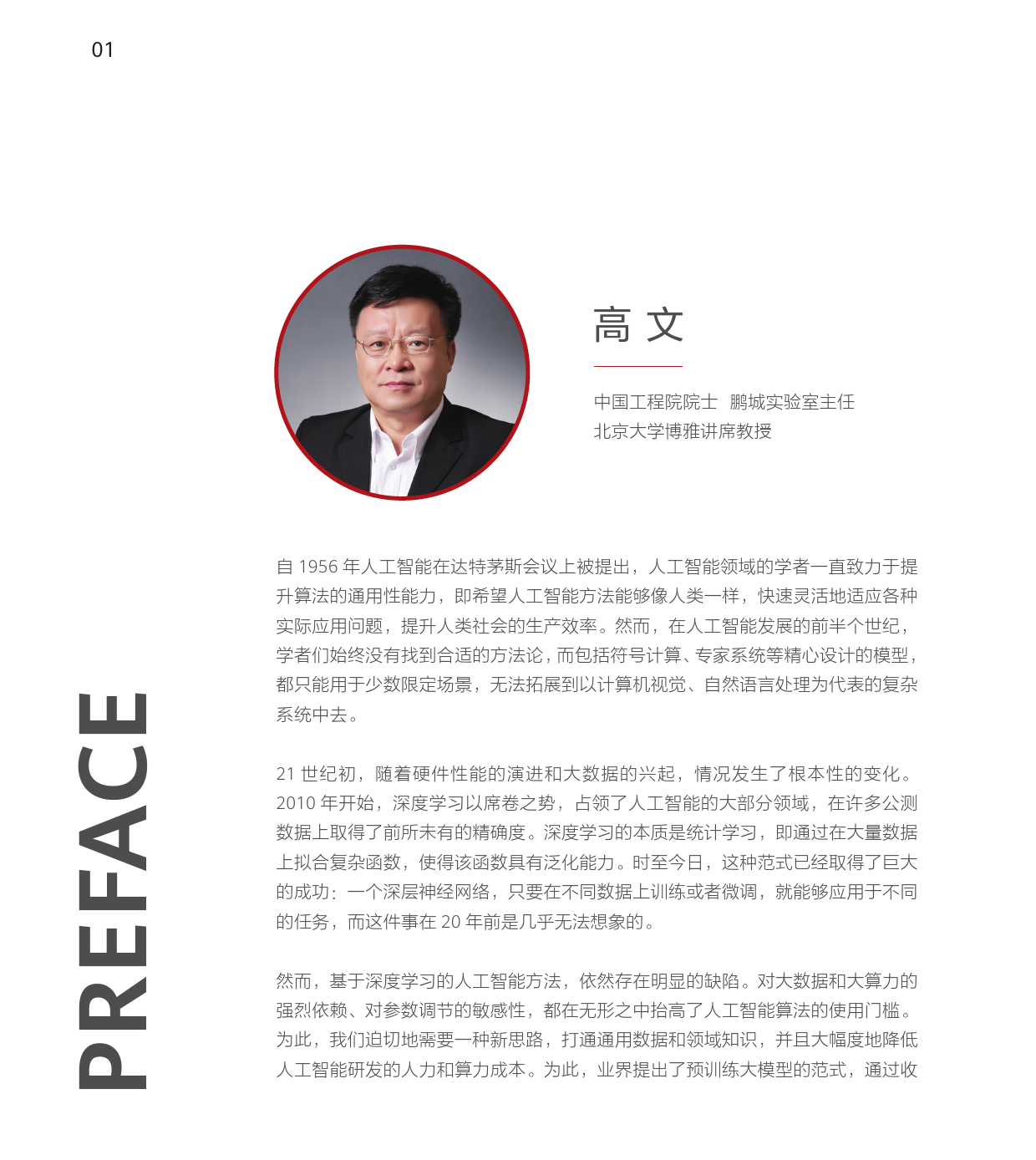

预训练大模型白皮书PREFACE01高文中国工程院院士鹏城实验室主任北京大学博雅讲席教授自1956年人工智能在达特茅斯会议上被提出,人工智能领域的学者一直致力于提升算法的通用性能力,即希望人工智能方法能够像人类一样,快速灵活地适应各种实际应用问题,提升人类社会的生产效率。然而,在人工智能发展的前半个世纪,学者们始终没有找到合适的方法论,而包括符号计算、专家系统等精心设计的模型,都只能用于少数限定场景,无法拓展到以计算机视觉、自然语言处理为代表的复杂系统中去。21世纪初,随着硬件性能的演进和大数据的兴起,情况发生了根本性的变化。2010年开始,深度学习以席卷之势,占领了人工智能的大部分领域,在许多公测数据上取得了前所未有的精确度。深度学习的本质是统计学习,即通过在大量数据上拟合复杂函数,使得该函数具有泛化能力。时至今日,这种范式已经取得了巨大的成功:一个深层神经网络,只要在不同数据上训练或者微调,就能够应用于不同的任务,而这件事在20年前是几乎无法想象的。然而,基于深度学习的人工智能方法,依然存在明显的缺陷。对大数据和大算力的强烈依赖、对参数调节的敏感性,都在无形之中抬高了人工智能算法的使用门槛。为此,我们迫切地需要一种新思路,打通通用数据和领域知识,并且大幅度地降低人工智能研发的人力和算力成本。为此,业界提出了预训练大模型的范式,通过收02集海量训练数据,并通过一种称为预训练的过程,将其中蕴含的知识存储于大规模神经网络,即大模型之中。如此,这个预训练大模型就具有了很强的泛化能力,并且可以通过简单的微调操作,将其能力应用到下游任务中...

发表评论取消回复