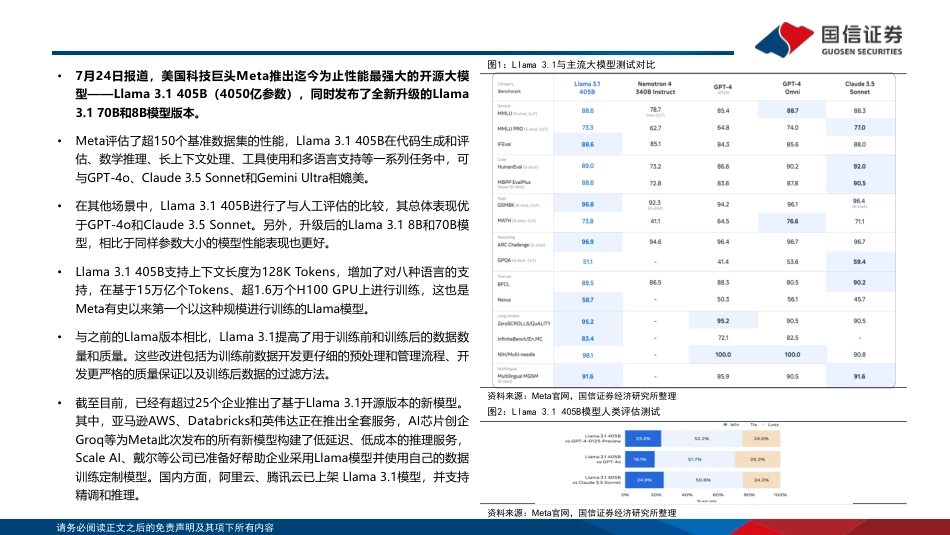

请务必阅读正文之后的免责声明及其项下所有内容2024年07月31日开源Llama3.1发布:对端云AI的影响行业研究·行业专题计算机·人工智能投资评级:优于大市(维持)证券分析师:熊莉021-61761067xiongli1@guosen.com.cnS0980519030002证券研究报告|请务必阅读正文之后的免责声明及其项下所有内容•Llama3.1发布,开源大模型王者易主。7月24日报道,美国科技巨头Meta推出迄今为止性能最强大的开源大模型——Llama3.1405B(4050亿参数),同时发布了全新升级的Llama3.170B和8B模型版本;Meta评估了超150个基准数据集的性能,Llama3.1405B在代码生成和评估、数学推理、长上下文处理、工具使用和多语言支持等一系列任务中,可与GPT-4o、Claude3.5Sonnet和GeminiUltra相媲美;在其他场景中,Llama3.1405B进行了与人工评估的比较,其总体表现优于GPT-4o和Claude3.5Sonnet。•开源引领,加速构建META生态。与闭源模型不同,Llama3.1是公开可用的模型,模型的权重可供下载;Llama3.1开源使得更广泛的开发者及社区可以为其应用程序定制模型,并在任何环境中运行,包括本地服务器、云端、笔记本电脑、甚至手机等,同时无需将数据分享给Meta。同时,Meta透露,其更新了许可证,允许开发人员首次使用包括405B参数规模的Llama模型的输出来改进其他模型。•未来预期:转向MOE结构,落地三种商业模式。MoE(混合专家模型)是一种基于Transformer架构的模型,旨在提高模型的计算效率和性能。其基本思想是通过多个“专家”网络(子模型)协同工作,根据输入数据的特征动态选择最合适的专家,从而优化计算资源的使用和模型的预测精度。基于Meta的商业模...

发表评论取消回复