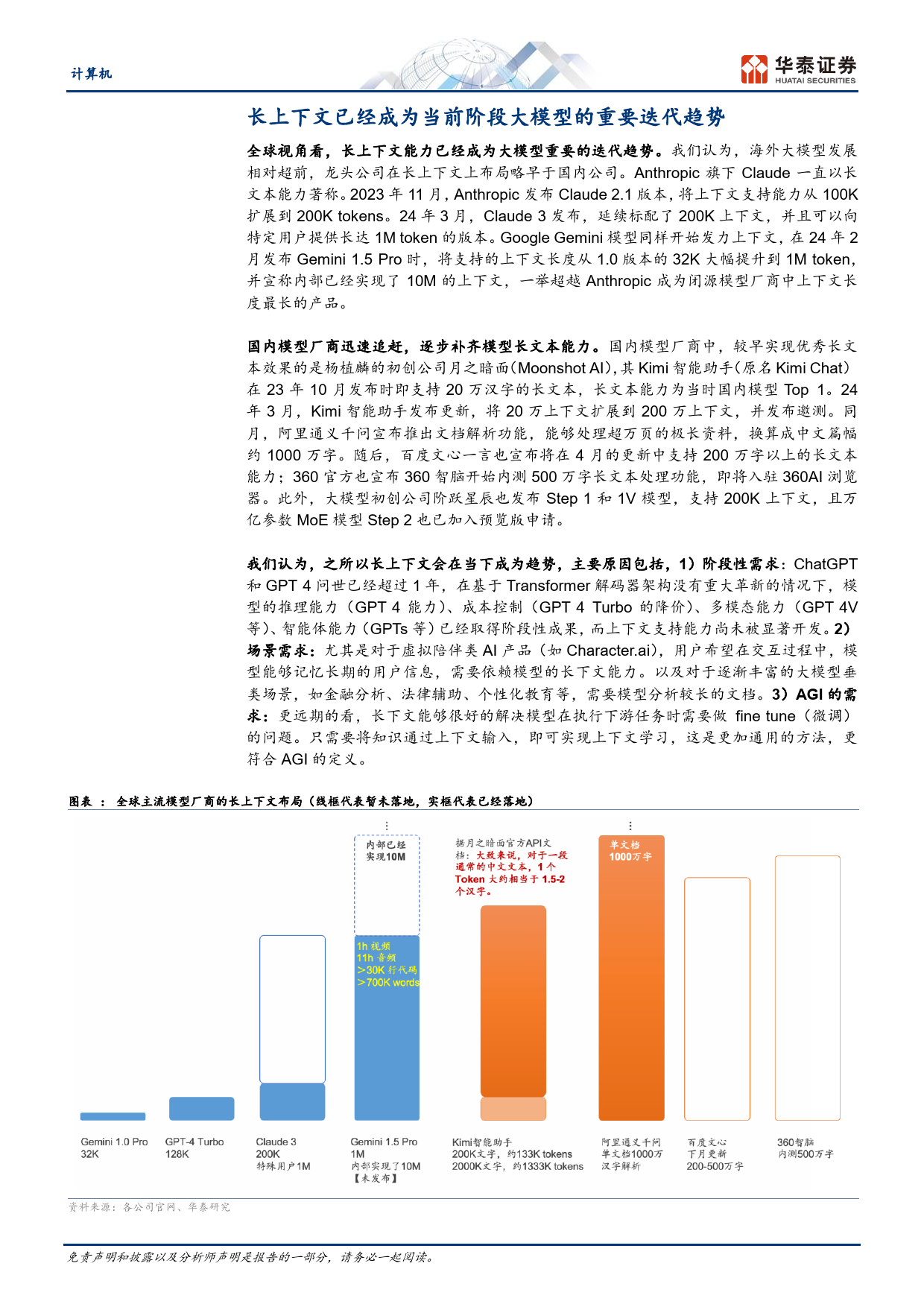

计算机通过Kimi,看长文本的实现华泰研究计算机增持(维持)2024年3月26日│中国内地专题研究Kimi上下文长度10倍增长,引领国内大模型长上下文迭代新方向研究员谢春生大模型的长上下文支持能力已经成为重要的迭代方向。海外相对超前,SACNo.S0570519080006SFCNo.BQZ938xiechunsheng@htsc.comAnthropicClaude3模型标配200K上下文,并可向特定客户提供1M长度;+(86)2129872036GoogleGemini1.5Pro标配支持1M上下文长度,内部已实现10M。国产大模型初创公司中,月之暗面的Kimi智能助手在23年10月即实现了20联系人袁泽世,PhD万字上下文,并在24年3月进一步迭代成为200万字。同月,阿里通义千SACNo.S0570122080053问宣布文档解析功能支持1000万字;百度文心一言将在4月的更新中支持yuanzeshi@htsc.com200万字以上的长文本能力;360智脑开始内测500万字长文本处理功能。长上下文已成为全球大模型迭代重要方向,关注其他国产模型厂商进展。行业走势图(%)计算机沪深3008Jul-23大模型长上下文,主要通过优化Transformer架构实现Nov-23Mar-24目前,全球大模型仍然以Transformer解码器为主要架构基础。在此基础上,(5)可以通过改进解码器架构来实现长上下文,主要改进方法包括:1)高效的注意力机制:降低计算成本,在训练时实现更长的序列长度,相应的推理时(19)序列长度也就更长;2)实现长期记忆:设计显式记忆机制,以解决上下文记忆的局限性。3)改进位置编码:对现有的位置编码进行改进,实现上下(32)文外推。4)对上下文进行处理:用额外的上下文预/后处理,确保每次调用中输入给LLM的输入始终满足最大长度要求。(45)Mar-23国内大模型厂...

发表评论取消回复