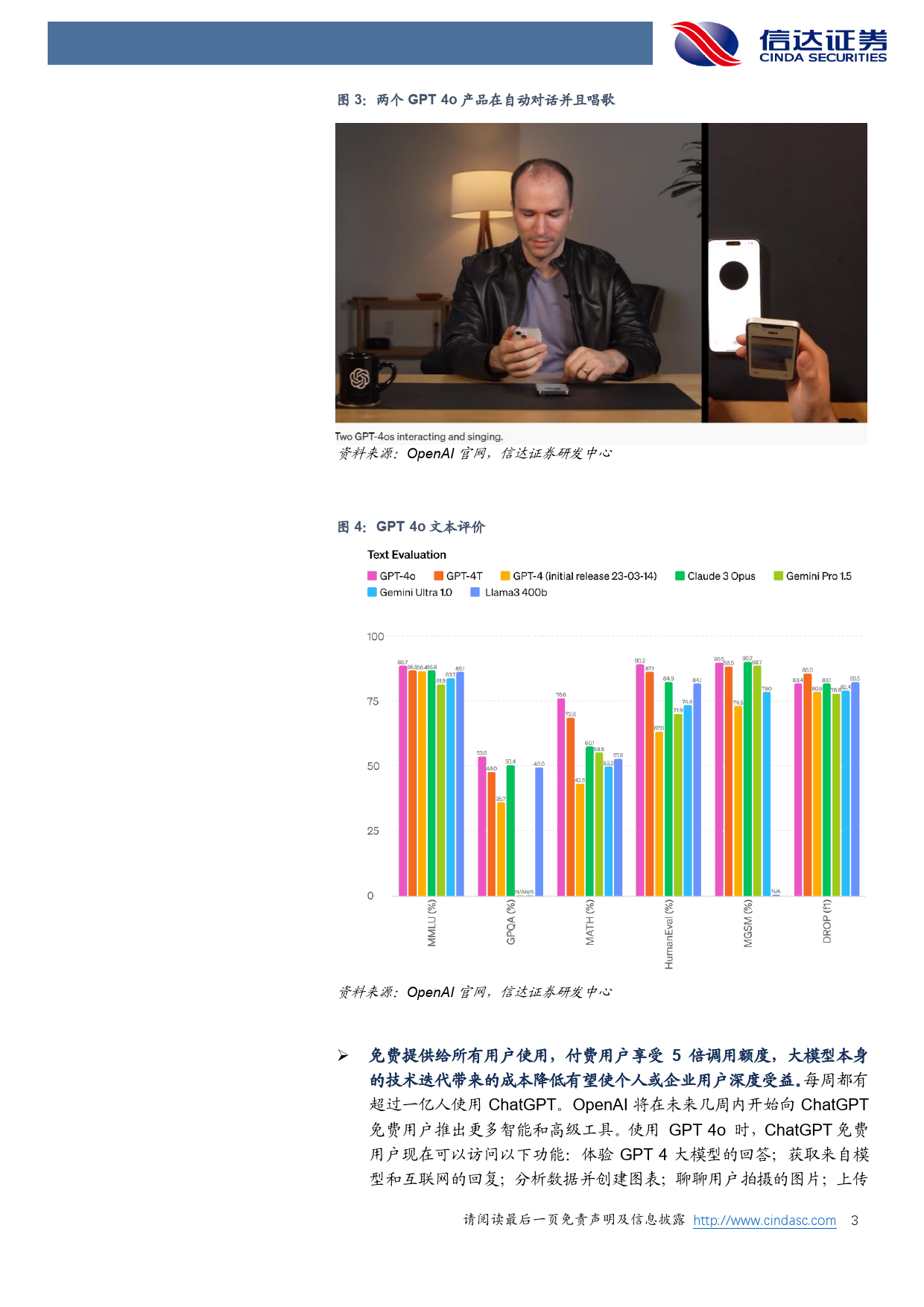

证券研究报告[大Tab模le_型Titl进e]程焦点:OpenAI春季发布会及谷歌开发者大会要点归纳行业研究[Table_ReportDate]2024年5月16日[Table_ReportType][T事ab件l:e_北Su京mm时ar间y]5月14日凌晨,OpenAI发布了最新模型GPT-4o,GPT-4o行业事项点评(“o”代表“omni”)接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像的任意组合输出。它可以在短至232毫秒的时间内响[Table_StockAndRank]应音频输入,平均为320毫秒,与人类的响应时间相似。它在英语文本和代码上的性能与GPT-4Turbo的性能相匹配,在非英语文本上的性能显著投资评级提高。与现有模型相比,GPT-4o在视觉和音频理解方面尤其出色。上次评级GPT-4o的文本和图像功能5月14日已经开始在ChatGPT中推出。OpenAI正在免费套餐中提供GPT-4o,并向Plus用户提供高达5倍的消息限制,[T冯ab翠le婷_Au传th媒or互]联网及海外首席分析未来几周将在ChatGPTPlus中推出新版语音模式GPT-4o的alpha版。开师发人员现在还可以在API中访问GPT-4o作为文本和视觉模型。与GPT-4执业编号:S1500522010001Turbo相比,GPT-4o速度提高2倍,价格降低一半,速率限制提高5倍。联系电话:17317141123OpenAI计划在未来几周内在API中向一小部分值得信赖的合作伙伴推出对邮箱:fengcuiting@cindasc.comGPT-4o新音频和视频功能的支持。[Table_OtherReport]在OpenAI发布会上,团队展示了GPT-4o的多个功能。包括实时语音交流能力,几乎无延迟,达到真人聊天的水平;可以识别用户的语音情绪,语音有情感;可以使用不同语言(英语、意大利语)和多人同时交互;在语音的同时可以与视频实时交互;实时...

发表评论取消回复